L’iOS del futuro potrebbe essere un sistema capace di leggere le emozioni dell’utente per anticipare i suoi desideri e i suoi gusti. E tutto ciò senza parlare né digitare niente. In questo modo Apple potrebbe vincere la battaglia contro Google e Microsoft.

iOS 7 è già piu “emozionale” dei suoi predecessori

L’interfaccia del iOS 7 si caratterizza per l’abbandono di metafore visive oramai inutili. Non c’è più il legno, né superfici metalliche né forme che ricordino oggetti reali in maniera scontata. Il diaframma che separava il sistema dall’utente non c’è più.

Per iOS la conseguenza di questo “buttar via i vecchi mobili” è che adesso la sua interfaccia sembra “respirare” come un “essere vivente”. Con iOS 7 vediamo il sistema operativo messo a nudo, senza maschere. Possiamo giocare con tutto, ottenere una risposta ad ogni tap. “Cosa vogliamo che senta la gente?”: questa è la domanda che il team di design della Apple si è posta di recente.

brightcove.createExperiences();

E la risposta, come mostra elegantemente il video con cui Apple ha presentato il suo nuovo sistema operativo, sono le emozioni fondamentali: allegria, sorpresa, amore… affetto. Ho scambiato le mie impressioni con vari redattori qui in Softonic, e il verdetto è lo stesso: iOS 7 è un sistema agile, elegante e comodo. Un terreno perfetto dove poter seminare quello che sta per arrivare.

Il software emozionale è già pronto.

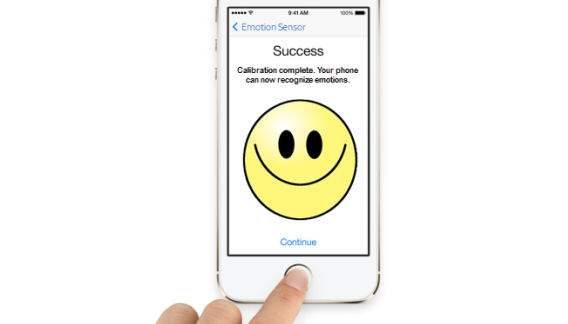

Le emozioni diventano sempre più importanti nel mondo del software e sarà un aspetto fondamentale dei sistemi operativi del futuro e delle applicazioni che verranno sviluppate fin da ora. Immaginate un sistema operativo capace di leggere le nostre emozioni basandosi sulle nostre espressioni facciali, sul tono della voce che usiamo o sulla resistenza elettrica della pelle. Sarebbe un sistema operativo capace di indovinare il nostro stato d’animo.

La app di Sension per Glass aiuta gli autistici a riconoscere le emozioni (fonte)

La app di Sension per Glass aiuta gli autistici a riconoscere le emozioni (fonte)

Gli usi di una “Emotion API” sono molti e emozionanti: migliori consigli per l’utente nello store; una pubblicità più in sintonia con lo stato d’animo dell’utente, e un’ampia gamma di impieghi per i giochi e le applicazioni social. In sostanza i metodi per questa analisi affettiva esistono già, e gli autori di software ne stanno esplorando le potenzialità. Per esempio Sension, una società di San Francisco, sta creando una app per Google Glass capace di leggere le emozioni.

Apple parteciperà a questa “rivoluzione emozionale”?

Quando ho visto che Apple lanciava un sistema di lettura delle impronte digitali, le sue intenzioni mi sono sembrate evidenti: stabilire un contatto non mediato tra il sistema e l’utente, senza intermediario e attraverso dei sensori diretti.

Fotomontaggio di come potrebbe essere il setup del riconoscimento facciale in iOS

Secondo me se Apple nei prossimi anni lanciasse una app con queste caratteristiche la cosa avrebbe senz’altro molto senso. Le emozioni degli utenti hanno sempre giocato un ruolo importante nelle scelte di design da parte di Apple, e questo è stato il segreto del suo successo.

Però non è sufficiente trasmettere emozioni positive attraverso il design: il passo successivo sarebbe quello di individuare e accompagnare le emozioni dell’utente per stabilire un legame definitivo tra uomo e macchina. Questo legame potrebbe giocare un ruolo fondamentale affinché iOS continui ad essere competitivo di fronte ad un Android e un Windows Phone che continuano a migliorare sotto tutti gli aspetti..

Permetteresti ad una app di leggere le tue emozioni?

[Adattamento di un articolo originale di Fabrizio Ferri-Benedetti per Softonic ES]